Potenciando la diversidad en conjuntos de datos para aprendizaje automático: el trabajo de Jocelyn Dunstan en NeurIPS 2024

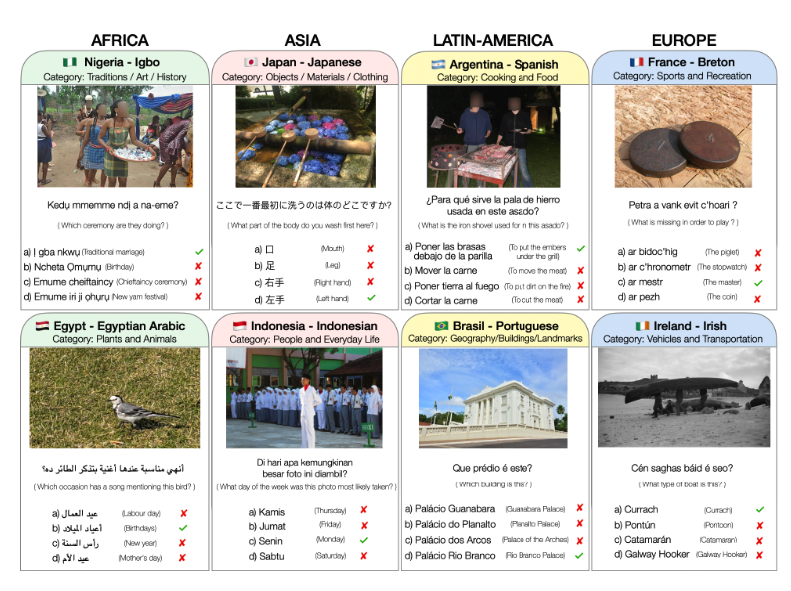

Noviembre, 2024.- Más de 9000 preguntas, en 26 idiomas y provenientes de 28 países, forman parte del trabajo realizado para «CVQA: Culturally-diverse Multilingual Visual Question Answering Benchmark», el paper aceptado en NeurIPS 2024 que tiene como co-autora a Jocelyn Dunstan Escudero, investigadora IMFD y académica IMC y DCC UC, junto a Paula Silva, coordinadora de comunicaciones del IMFD. NeurIPS se ha convertido en la conferencia más prestigiosa del mundo en el área de aprendizaje computacional.

Un problema de representatividad

“La respuesta a preguntas visuales (VQA) es una tarea importante en las inteligencias artificiales multimodales, que requieren modelos para comprender y razonar sobre el conocimiento presente en los datos visuales y textuales”, detalla la investigadora. Sin embargo, la mayoría de los conjuntos de datos y modelos de este tipo, se centran principalmente en el inglés y en algunos de los principales idiomas del mundo, con imágenes centradas en lo que se conoce generalmente como norte global, dejando con poca representación al resto del mundo. “Aunque en los últimos tiempos se ha intentado aumentar el número de lenguas incluidas en estos conjuntos de datos, sigue faltando diversidad en las lenguas de escasos recursos”, explica Jocelyn Dunstan, destacando que si bien algunos conjuntos de datos amplían el texto a otros idiomas, ya sea mediante traducción u otros métodos, suelen mantener las mismas imágenes, lo que da lugar a una representación cultural limitada.

Este es el marco para la creación de «CVQA: Culturally-diverse Multilingual Visual Question Answering Benchmark», un nuevo conjunto de datos de referencia de respuesta a preguntas visuales multilingües culturalmente diversas, diseñado para cubrir un rico conjunto de idiomas y regiones, en el que se buscó activamente sumar a hablantes nativos y expertos culturales en el proceso de recopilación de datos.

En el paper, presentado oralmente en NeurIPS, se destaca la inclusión de imágenes y preguntas culturales de 28 países de cuatro continentes, 26 idiomas y 11 alfabetos, con un total de 9.000 preguntas. “Comparamos varios modelos Multimodal Large Language Models (MLLM) con CVQA y demostramos que el conjunto de datos supone un reto para los modelos más avanzados. Esta prueba servirá como conjunto de evaluación de sondeo para evaluar el sesgo cultural de los modelos multimodales y esperamos que fomente más esfuerzos de investigación para aumentar la conciencia cultural y la diversidad lingüística en este campo”, destacan en la investigación presentada.

Para Paula Silva, “este fue un trabajo que me permitió ocupar una gran diversidad de conocimientos sobre la cultura chilena, y que además fue muy entretenido de realizar, ya que teníamos que buscar las imágenes, respetando siempre los derechos de autor, y luego ir creando las preguntas y respuestas en base a lo que fuese reconocible para una persona chilena”. Sobre la oportunidad de participar en un estudio como este, destaca que “la incorporación de diversidad y búsqueda de representatividad de diferentes culturas es uno de los desafíos más importantes que tiene el desarrollo de la IA actualmente, y desde este punto, el aporte que podemos hacer desde los países del cono sur es muy relevante”.

NeurIPS se realiza desde 1987 y se ha convertido en la conferencia más prestigiosa del mundo en su ámbito. Cada año congrega a más de 10.000 académicos y representantes de la industria, es sumamente competitiva. En cada llamado para la recepción de contribuciones, se recopilan alrededor de 10.000 publicaciones científicas de investigadores especializados en diversos campos ligados al machine learning y la inteligencia artificial, tales como neurociencia y procesamiento del lenguaje natural.

Revisa el video sobre la investigación en: https://www.instagram.com/reel/DCjx1rpOi5n/