Denis Parra y su trabajo en IA y arte: reemplazar al ser humano está lejos de ocurrir

Denis Parra, académico de Computación de la Universidad Católica e investigador del Instituto Milenio Fundamentos de los Datos (IMFD), viene trabajando desde hace años en un área menos explorada dentro de la inteligencia artificial (IA): su aplicación en el arte y los procesos creativos en general.

-¿Qué impacto está teniendo el uso de IA en el arte y los procesos creativos?

-El impacto en el último tiempo ha sido importante por la cantidad de técnicas y herramientas disponibles. Pero a la vez es un poco sobrevalorado porque si bien se han automatizado algunas cosas, aún no es posible eliminar al ser humano del proceso artístico y de los procesos creativos.

-¿Cómo describirías ese uso o aplicación, en la práctica?

-Por un lado han aumentado mucho las herramientas de IA que permiten diversificar y apoyar el proceso creativo tanto visual -para pintura, fotografía y video- como sonoro, para generar música. También está la generación de texto, gracias el modelo de IA llamado GPT2, que fue inventado el año pasado. Este muestra que es posible iniciar una oración y que la IA desarrolle una historia a partir de ese enunciado, que se lee como si la hubiese escrito un humano. Existe además la posibilidad de combinar estos diferentes modos de arte. Sin embargo, reemplazar completamente a un humano, tanto en el proceso creativo como en la elección del mensaje o tema a presentar, está un poco lejos de ocurrir.

–¿Se han vendido piezas de arte desarrolladas por IA, por ejemplo?

-Sí, se han vendido pinturas hechas por IA, como un cuadro que se comercializó en 2018, en la conocida casa de remates Christie’s, llamado «Portrait of Edmond de Belamy» (https://bit.ly/2IvFtQp), del colectivo Obvious. Ellos están ubicados en París, Francia. Este cuadro se realizó con un modelo de IA llamado GAN y se vendió en más de US$ 400 mil. Sin embargo, igual hubo intervención humana ahí: qué pinturas usar para entrenar la red y qué cuadro elegir para llevar a la subasta.

El proceso no es 100% automático. Esta venta de «Portrait of Edmond de Belamy» generó mucho interés y una segunda obra de arte, de Mario Klingemann, que es más bien una instalación con un sistema que genera retratos de forma constante. Este se remató en la casa de subastas Sotheby’s, en marzo de 2019, logrando una venta de 40 mil libras, es decir, poco más de US$ 50 mil.

-¿Cuándo y dónde surge esto como área de investigación o aplicación?

-El uso de IA para arte se viene viendo desde hace décadas, pero en los últimos años sin duda han habido importantes avances. Dentro de los grandes avances en los últimos cinco años, que comprenden la irrupción de los modelos de Deep learning o aprendizaje profundo, podemos contar con los llamados modelos generativos: GANs (Generative Adversarial Networks) y VAEs (Variational Autoencoders).

Recientemente han aparecido también los «flow-based models» que a diferencia de GANs y VAEs, son reversibles, es decir, se puede volver atrás en el proceso creativo con IA y modificar/manipular mejor ciertas «entradas». Estos últimos tienen potencial para ser más eficientes en algunas tareas que los modelos generativos originales.

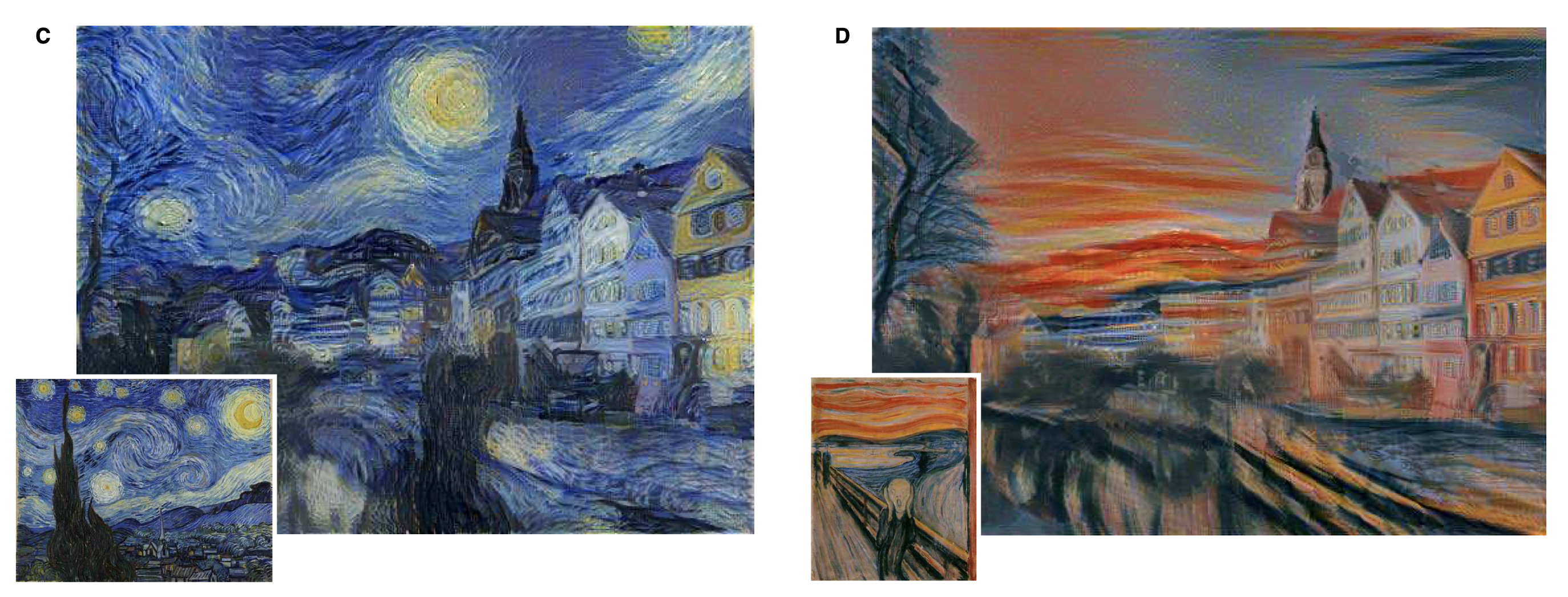

Otro ejemplo del cual se habla mucho y que incluso tiene aplicaciones actualmente es el llamado «transferencia de estilo», que surge de un trabajo en 2015 de Gatys y otros autores, de la Universidad de Tubingen, en Alemania. Este permite dar un estilo artístico a elección -como las pinturas de Picasso o Van Gogh- a cualquier imagen de entrada (https://bit.ly/2TM4Brl)

Sistemas de recomendación visuales y musicales

-¿De qué se trata el trabajo que has desarrollado sobre IA y arte?

-Llevamos unos 3 a 4 años trabajando en sistemas de recomendación de arte. Esto ha sido el punto de partida porque empezamos a usar modelos de redes neuronales profundos para recomendar música y pinturas. Uno de estos papers se llama «Content-based artwork recommendation: integrating painting metadata with neural and manually-engineered visual features». Ahí mostramos cómo hacer recomendaciones de pinturas usando redes neuronales: https://link.springer.com/article/10.1007/s11257-018-9206-9

Otro trabajo que desarrollé es un sistema que permite explorar visualmente artistas musicales y obtener recomendaciones, como usuario, en base a la emoción que proyectan los artistas que la persona elige. Se llama moodplay: http://moodplay.pythonanywhere.com/

-¿A qué apunta tu investigación en esta área? ¿Qué impacto puede tener?

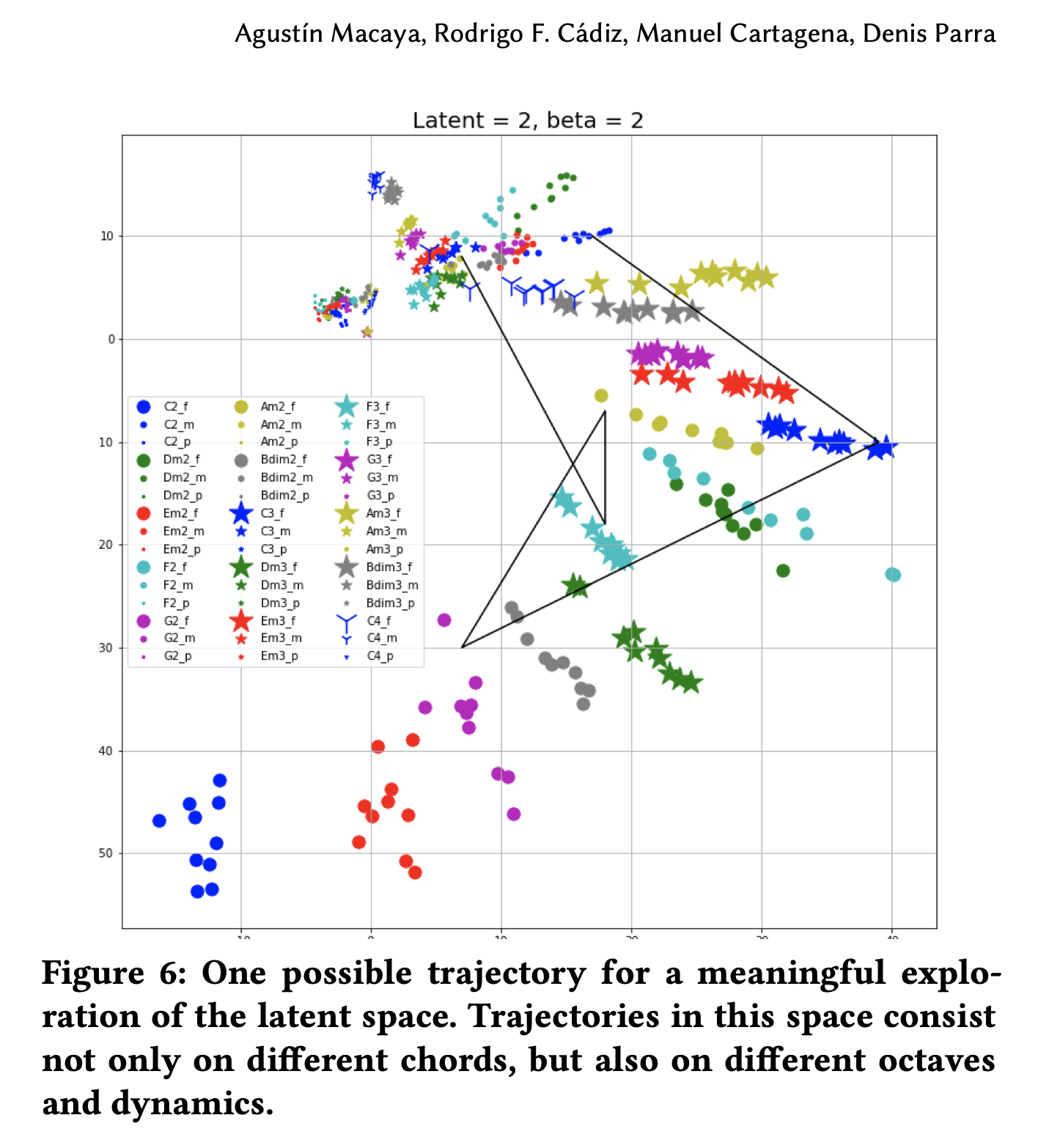

-Mi investigación actual va tanto en el área visual como musical; está última en colaboración con el profesor Rodrigo Cádiz, académico de los institutos de Música e Ingeniería Eléctrica de la U. Católica. Desde el año pasado tenemos un grupo de alumnos trabajando en el CreativAI UC Lab (https://creativai-uc.github.io/) y el primer resultado es un sistema basado en VAEs, que aprende a codificar y reconstruir acordes de piano. Pero además puede crear acordes nuevos no escuchados previamente por la red. A partir de esto incluso se pueden crear secuencias de acordes mezclando tanto los acordes nuevos como los generados en tiempo real. Esperamos implementar y liberar esta herramienta en la web durante 2020.

A partir de este punto pudimos saltar a usar modelos para generar contenido. De hecho, estamos formando alumnos en temas de generación de contenido musical y visual, creando herramientas que pueden servir para público general y para artistas, en su proceso creativo. Esperamos tener algunos resultados en los próximos meses.

-¿Y en lo visual específicamente?

-Estamos trabajando en recomendación de imágenes; transferencia de estilo artístico de obras presentes en el Museo de Bellas Artes de Santiago; y generación personalizada de arte, así como algunas aplicaciones para arquitectura.

-¿Hay alumnos trabajando en estos proyectos?

-Sí, en recomendación visual están los alumnos Pablo Messina, Felipe del Río, Patricio Cerda y Manuel Cartagena. En generación visual, Jorge Pérez Facuse y Eugenio Herrera. En lo musical, Agustín Macaya y Manuel Cartagena. Y en generación visual para arquitectura, Isidora Palma. Todos son estudiantes de la U. Católica.

-¿De qué manera tu línea de trabajo puede ayudar a los artistas?

-El trabajo presenta nuevas posibilidades de IA para la divulgación del arte que los artistas realizan actualmente. También amplía el horizonte actual de la creación artística, mostrándoles herramientas de IA que pueden ser de utilidad para arte visual, musical y de texto.

-¿Este uso de la IA amenaza con terminar con los procesos creativos desarrollados por las personas?

-Si bien en este punto hay algo de discrepancia, comparto la opinión del investigador Aaron Hertzmann, quien en un artículo llamado «Can Computers Make Art» hace un paralelo entre la tecnología de IA actual y la aparición de la cámara fotográfica. En resumen, él cree que el arte está principalmente en el mensaje que quiere dar el artista. La verdad es que estando lejos aún de la IA general -sistemas independientes y flexibles que puedan decidir por sí mismos qué aprender, cómo hacerlo y hacer inferencia y conexiones entre distintas áreas del saber y del arte-, no veo que los modelos actuales tengan la intención de expresar algo y así generar arte. En la práctica siguen siendo herramientas, sofisticadas pero herramientas al fin, y no creadores de arte.

-¿Hay otros aspectos a considerar respecto al impacto de la IA en el arte?

-Sí, aspectos de copyright no resueltos, como quién tiene los derechos de la obra. ¿El artista o el algoritmo que la produce?

Además, aplicaciones de tipo artístico como las que permiten manipular estilo, pueden utilizarse para sintetizar imágenes o videos con fines políticos, o para chantajear gente, como los deep fakes. Finalmente, existe un potencial riesgo de facilitar el plagio o el mercado negro de copias a originales.