Investigador IMFD será presentador en importante conferencia sobre lógica y autómatas

La edición 2024 de Highlights se desarrollará entre el 16 y el 20 de septiembre en la Universidad de Bordeaux (Francia). La charla que dictará Pablo Barceló abarcará tres casos de estudio que resaltan el rol clave de la lógica para mejorar la comprensión de las arquitecturas modernas de aprendizaje automático.

El Laboratoire Bordelais de Recherche en Informatique (LaBRI), que funciona en la Universidad de Bordeaux (Francia) y congrega a más de 100 investigadores, será este año la sede de Highlights, una de las conferencias más importantes del mundo en los ámbitos de teoría de modelos, teoría de autómatas, bases de datos y juegos para lógica y verificación. La versión 2024, que se realizará entre el 16 y el 20 de septiembre, contará con la presencia de cuatro oradores invitados, incluyendo a Pablo Barceló, director del Instituto de Ingeniería Matemática y Computacional (IMC UC).

“Highlights reúne los mejores trabajos de las conferencias más relevantes de distintas áreas. Es una conferencia informal donde no hay proceedings, que son las colecciones de papers que se publican en el contexto de una reunión académica. En cambio, la gente envía los mejores trabajos que ya han sido publicados anteriormente y, por eso, es la gran reunión de quienes trabajan en áreas como la lógica para ciencias de la computación y los autómatas”, comenta Barceló, doctor en ciencias de la computación e investigador del Centro Nacional de Inteligencia Artificial (CENIA) y el Instituto Milenio Fundamentos de los Datos (IMFD).

El académico agrega que, con el objetivo de ofrecer una mirada amplia a los últimos avances en las distintas áreas que abarca la conferencia, cada año los organizadores incluyen speakers que son investigadores reconocidos en sus respectivos campos. Durante esta edición, junto a Barceló se presentarán Albert Atserias (Universidad Politécnica de Cataluña), Mikołaj Bojańczyk (Universidad de Varsovia, Polonia) y Laure Daviaud (Universidad de East Anglia, Reino Unido). “Además de la gente que expone papers en sólo 10 minutos, están los presentadores principales que dan charlas más extensas de una hora. En mi caso, es la primera vez que me invitan”, señala.

Pablo Barceló, director del IMC.

La charla que dictará el director del IMC en Francia se titulará “The Role of Logic in Advancing Machine Learning: Three Case Studies” y abarcará casos de estudio que resaltan el rol esencial de la lógica para mejorar la comprensión de las arquitecturas modernas de aprendizaje automático. Los primeros dos trabajos son “Logical Languages Accepted by Transformer Encoders with Hard Attention” y “The Logical Expressiveness of Graph Neural Networks”, en los que también participan, respectivamente, los investigadores Alexander Kozachinskiy (postdoc IMC UC/ CENIA/ IMFD) y Juan Reutter (académico IMC/ Departamento de Ciencia de la Computación UC y director del IMFD). El tercero se llama “A Uniform Language to Explain Decision Trees” y tiene como uno de sus coautores a Marcelo Arenas (IMC / Departamento de Ciencia de la Computación UC e investigador IMFD).

“Lo que quiero mostrar es que los aspectos lógicos de la ciencia de la computación pueden ser utilizados para entender las capacidades que tienen los modelos actuales de inteligencia artificial. Nosotros trabajamos en tres áreas; una se refiere a las redes neuronales de grafos, otra es el poder expresivo de los transformers, que son las arquitecturas que están por detrás de los modelos de lenguaje com ChatGPT. Finalmente, abordamos la interpretabilidad de los modelos. Es decir, cómo explico las decisiones que toman, mostrando en cada uno de ellos que la lógica puede ser una herramienta importante para entender qué es lo que se puede hacer y cuál es el costo computacional”, indica Barceló.

La revolución de los transformers

Los modelos de transformers se originaron a partir de un artículo publicado por investigadores de Google en 2017 y que llevaba por título “Attention Is All You Need”, constituyéndose rápidamente en uno de los desarrollos más influyentes en el campo del machine learning. Tal como señala el director del IMC, su arquitectura es fundamental en los modelos de lenguaje de vanguardia de OpenAI como ChatGPT, además de ser clave en la creación de software como AlphaStar de DeepMind.

“Los transformers son modelos de lenguaje que reconocen secuencias de símbolos, de palabras. Entonces, desde el punto de vista matemático, es interesante entender cuáles lenguajes pueden ser reconocidos por los transformers y cuáles no. Para eso, lo que hacemos es formalizar un modelo de computación detrás de los transformers y estudiar ese modelo en base a cuáles son los lenguajes que puede aceptar, lo cual genera vínculos con la teoría lógica de lenguajes y la teoría de autómatas, que también son objetos matemáticos que procesan secuencias”, señala Barceló.

Los transformers se han vuelto esenciales para aplicaciones como ChatGPT.

Este trabajo resulta esencial para el desarrollo que actualmente tienen los transformers, cuya aplicación se puede apreciar en chatbots, asistentes virtuales y otros sistemas interactivos de inteligencia artificial donde una conversación dinámica con los usuarios es vital. “Hoy estamos viendo que pueden generar y mejorar textos. Pero con el refinamiento de esos modelos también se van a ocupar para abordar datos multimodales, que no son sólo textos, sino que también abarcan imágenes o sonidos. Estos transformers van a ser capaces de extraer información de todas esas fuentes como si correspondiera a un solo tipo de datos”, explica el investigador.

El potencial de los grafos

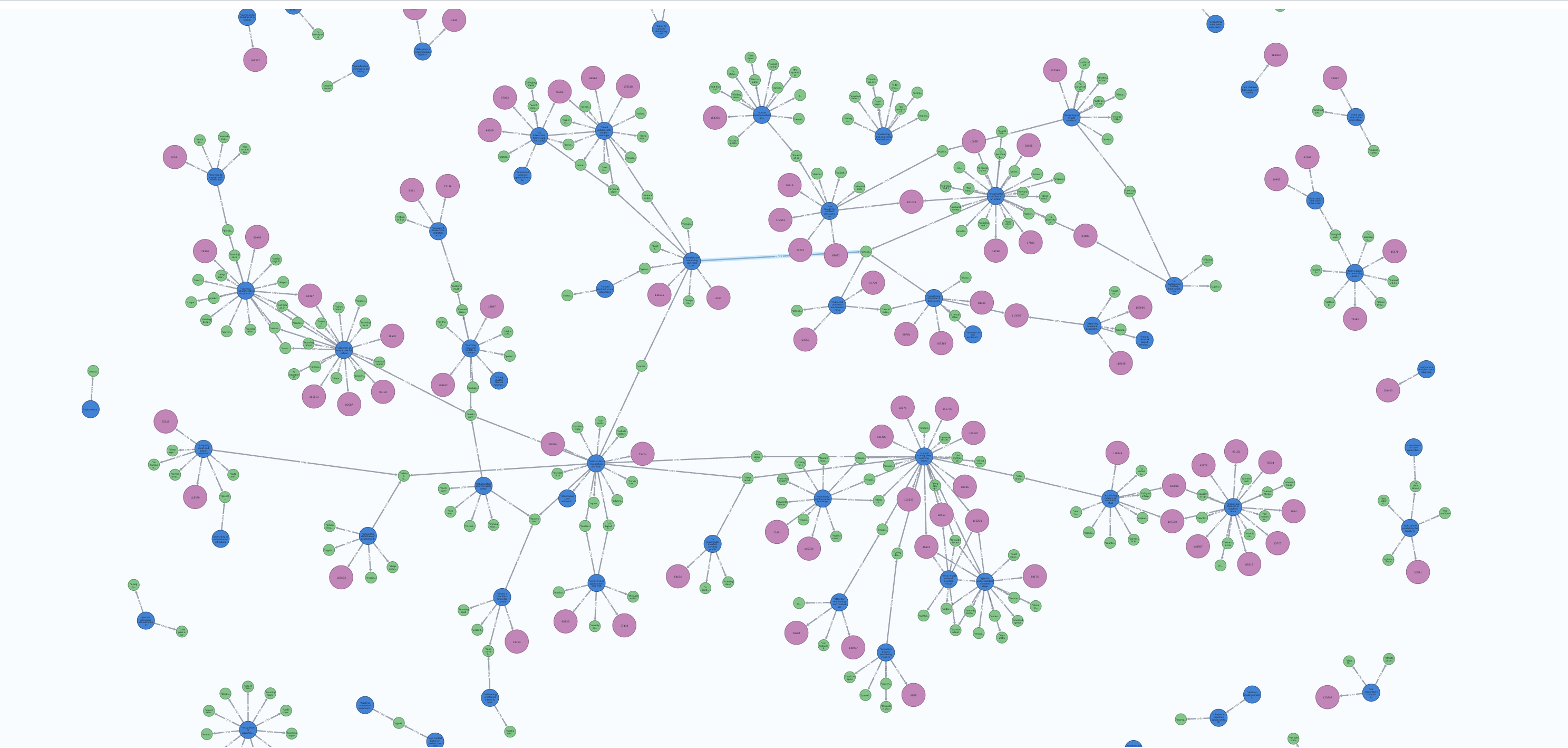

Un grafo es una estructura de datos matemática que consta de un conjunto de vértices -llamados nodos- y un conjunto de aristasue conectan estos vértices. En los años 80, los investigadores comenzaron a explorar formas de aplicar redes neuronales a datos organizados como grafos, aunque no fue hasta inicios de la década de 2010 que las redes neuronales de grafos comenzaron a hacerse más conocidas, producto del desarrollo de nuevas arquitecturas y algoritmos de aprendizaje.

“Estas redes neuronales son modelos que procesan información que está estructurada en base a grafos. Nosotros analizamos cuáles son las propiedades de los grafos que pueden ser reconocidas por una red neuronal de este tipo y para eso empleamos métodos lógicos. Demostramos que toda expresión que puede ser expresada con cierta lógica, puede ser expresada en una red neuronal de grafos y viceversa. Si hay una expresión lógica que puede ser reconocida por una red neuronal de grafos, entonces es expresable en esta lógica. Es como una relación uno a uno entre ambas cosas”, explica Barceló.

Las redes neuronales de grafos han experimentado importantes avances en los últimos años

Hoy estas redes tienen aplicaciones que abarcan diversos ámbitos. “Por ejemplo, las redes neuronales de grafos se ocupan para la detección de fraudes en bancos. Si tienes un grafo de transacciones, con una red neuronal puedes empezar a detectar áreas donde hay operaciones que se ven extrañas. También se utilizan para optimizar redes de transporte. En el desarrollo de nuevas drogas también son muy útiles, ya que pueden mostrar que los fármacos que tienden a atacar ciertas enfermedades de manera más efectiva se apegan a una cierta estructura molecular. Con esa información, puedes llegar a generar otro medicamento nuevo”, señala el director del IMC.

La inteligencia artificial explicable

El tercer estudio que presentará Barceló en Francia aborda la búsqueda de una inteligencia artificial explicable y demuestra cómo se puede utilizar la lógica de primer orden para diseñar lenguajes que declaren, evalúen y calculen explicaciones para las decisiones tomadas por modelos de aprendizaje automático.

“En el fondo, los modelos funcionan como cajas negras, ya que entendemos muy poco cómo toman las decisiones. Por eso existe una tendencia cada día más importante de tratar de diseñar modelos que sean más explicables, que de alguna forma entreguen razones por las cuales adoptaron ciertas determinaciones”, señala el académico.

Un ejemplo se da cuando un banco utiliza alguno de estos modelos para otorgar o rechazar un crédito a un cliente: “Es importante saber en qué criterio se basó para llegar a esa decisión y no que el modelo simplemente entregue una respuesta. Al final esos criterios son nociones matemáticas que también se pueden formalizar a través de la lógica”. Esto porque hoy se quiere que las “explicaciones que se obtienen entreguen garantías matemáticas, y que sean las mejores o las más concisas o eficientes”.

Fuente: IMC UC